Поиск файлов на компьютере вручную может стать довольно длительной процедурой, если на вашем компьютере отсутствует порядок и файлы не распределены по тематическим каталогам. С другой стороны, если в компьютере используется хорошая поисковая система с индексацией, то доступ к нужному файлу можно получить достаточно быстро. Cidaemon.exe является одним из основных Windows приложений, которое принимает участие в индексации файлов на компьютере. Файл Cidaemon.exe не является вирусом или вредоносным приложением. Удалив это системное приложение на своем компьютере, вы рискуете получить проблему в работе системы поиска файлов.

Поиск файлов на компьютере вручную может стать довольно длительной процедурой, если на вашем компьютере отсутствует порядок и файлы не распределены по тематическим каталогам. С другой стороны, если в компьютере используется хорошая поисковая система с индексацией, то доступ к нужному файлу можно получить достаточно быстро. Cidaemon.exe является одним из основных Windows приложений, которое принимает участие в индексации файлов на компьютере. Файл Cidaemon.exe не является вирусом или вредоносным приложением. Удалив это системное приложение на своем компьютере, вы рискуете получить проблему в работе системы поиска файлов.

Принцип работы Cidaemon.exe Читать далее За что отвечает системное приложение Cidaemon? →

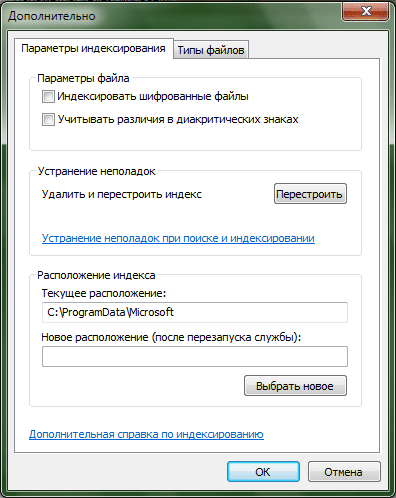

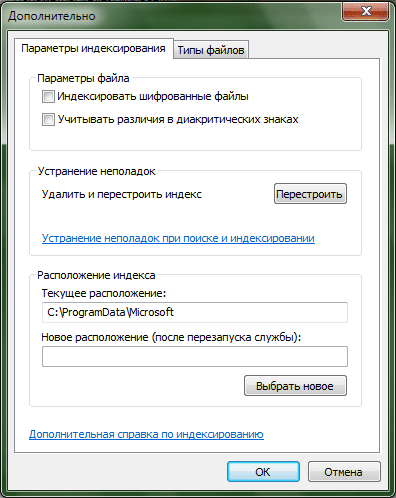

Раздел стартового меню «Windows Search» или «Найти» является средством запуска соответствующей утилиты, встроенной в Windows, которая позволяет выполнять поиск среди данных разного формата, хранимых на компьютере. Поиск по контенту является достаточно трудоемкой процедурой и для того, чтобы иметь возможность получить результаты в кратчайшие сроки, необходимо выполнение такой процедуры, как поисковая индексация файлов по всему жесткому диску системы.

Раздел стартового меню «Windows Search» или «Найти» является средством запуска соответствующей утилиты, встроенной в Windows, которая позволяет выполнять поиск среди данных разного формата, хранимых на компьютере. Поиск по контенту является достаточно трудоемкой процедурой и для того, чтобы иметь возможность получить результаты в кратчайшие сроки, необходимо выполнение такой процедуры, как поисковая индексация файлов по всему жесткому диску системы.

Что такое индексация Читать далее Для чего Windows выполняет поисковую индексацию? →

Среди многих сервисов, устанавливаемых вместе с операционной системой Windows XP, есть много бесполезных и ресурсоемких служб, которые можно безопасно отключить. Особенно хотелось бы выделить сервис индексации, по умолчанию запускаемый после загрузки системы. Разработчик предлагает использовать его для ускорения поиска файлов. Но, если вы используете другие приложения с этой целью (например, Google Desktop), то его можно смело отключить.

Среди многих сервисов, устанавливаемых вместе с операционной системой Windows XP, есть много бесполезных и ресурсоемких служб, которые можно безопасно отключить. Особенно хотелось бы выделить сервис индексации, по умолчанию запускаемый после загрузки системы. Разработчик предлагает использовать его для ускорения поиска файлов. Но, если вы используете другие приложения с этой целью (например, Google Desktop), то его можно смело отключить.

В процессе работы сервис индексации достаточно сильно нагружает процессор и память на каждом компьютере, особенно там, где огромное количество файлов. Давайте попробуем отключить этот сервис. Читать далее Как уменьшить нагрузку на процессор и память? Отключаем сервис индексации в Windows XP →

Файл robots.txt является набором инструкций для программ-роботов, сканирующих все WEB ресурсы сети Интернет, в том числе и ваш сайт. Поисковые алгоритмы таких интернет-гигантов поиска, как Google и Bing, используют Web-роботы для индексации всех страниц, которые они находят в Сети. По умолчанию, эти роботы пытаются проанализировать весь ваш сайт. В тоже время, большинство сайтов имеют такую информацию, которая не должна быть проиндексирована, так как является либо техническими данными администратора сайта, либо просто не подлежит публикации. Файл robots.txt позволяет определить, какие ресурсы сайта не должны попасть в индексацию роботами. Стоит учитывать, что разные вредоносные и шпионские роботы могут игнорировать инструкции этого файла, поэтому не используйте его для закрытия доступа к секретным данным.

Файл robots.txt является набором инструкций для программ-роботов, сканирующих все WEB ресурсы сети Интернет, в том числе и ваш сайт. Поисковые алгоритмы таких интернет-гигантов поиска, как Google и Bing, используют Web-роботы для индексации всех страниц, которые они находят в Сети. По умолчанию, эти роботы пытаются проанализировать весь ваш сайт. В тоже время, большинство сайтов имеют такую информацию, которая не должна быть проиндексирована, так как является либо техническими данными администратора сайта, либо просто не подлежит публикации. Файл robots.txt позволяет определить, какие ресурсы сайта не должны попасть в индексацию роботами. Стоит учитывать, что разные вредоносные и шпионские роботы могут игнорировать инструкции этого файла, поэтому не используйте его для закрытия доступа к секретным данным.

Инструкция Читать далее Как создать файл robots.txt для Web-сайта? →

Компьютерная помощь в Самаре оперативно, надежно, недорого

Поиск файлов на компьютере вручную может стать довольно длительной процедурой, если на вашем компьютере отсутствует порядок и файлы не распределены по тематическим каталогам. С другой стороны, если в компьютере используется хорошая поисковая система с индексацией, то доступ к нужному файлу можно получить достаточно быстро. Cidaemon.exe является одним из основных Windows приложений, которое принимает участие в индексации файлов на компьютере. Файл Cidaemon.exe не является вирусом или вредоносным приложением. Удалив это системное приложение на своем компьютере, вы рискуете получить проблему в работе системы поиска файлов.

Поиск файлов на компьютере вручную может стать довольно длительной процедурой, если на вашем компьютере отсутствует порядок и файлы не распределены по тематическим каталогам. С другой стороны, если в компьютере используется хорошая поисковая система с индексацией, то доступ к нужному файлу можно получить достаточно быстро. Cidaemon.exe является одним из основных Windows приложений, которое принимает участие в индексации файлов на компьютере. Файл Cidaemon.exe не является вирусом или вредоносным приложением. Удалив это системное приложение на своем компьютере, вы рискуете получить проблему в работе системы поиска файлов.

Раздел стартового меню «Windows Search» или «Найти» является средством запуска соответствующей утилиты, встроенной в Windows, которая позволяет выполнять поиск среди данных разного формата, хранимых на компьютере. Поиск по контенту является достаточно трудоемкой процедурой и для того, чтобы иметь возможность получить результаты в кратчайшие сроки, необходимо выполнение такой процедуры, как поисковая индексация файлов по всему жесткому диску системы.

Раздел стартового меню «Windows Search» или «Найти» является средством запуска соответствующей утилиты, встроенной в Windows, которая позволяет выполнять поиск среди данных разного формата, хранимых на компьютере. Поиск по контенту является достаточно трудоемкой процедурой и для того, чтобы иметь возможность получить результаты в кратчайшие сроки, необходимо выполнение такой процедуры, как поисковая индексация файлов по всему жесткому диску системы.  Среди многих сервисов, устанавливаемых вместе с операционной системой Windows XP, есть много бесполезных и ресурсоемких служб, которые можно безопасно отключить. Особенно хотелось бы выделить сервис индексации, по умолчанию запускаемый после загрузки системы. Разработчик предлагает использовать его для ускорения поиска файлов. Но, если вы используете другие приложения с этой целью (например, Google Desktop), то его можно смело отключить.

Среди многих сервисов, устанавливаемых вместе с операционной системой Windows XP, есть много бесполезных и ресурсоемких служб, которые можно безопасно отключить. Особенно хотелось бы выделить сервис индексации, по умолчанию запускаемый после загрузки системы. Разработчик предлагает использовать его для ускорения поиска файлов. Но, если вы используете другие приложения с этой целью (например, Google Desktop), то его можно смело отключить.  Файл robots.txt является набором инструкций для программ-роботов, сканирующих все WEB ресурсы сети Интернет, в том числе и ваш сайт. Поисковые алгоритмы таких интернет-гигантов поиска, как Google и Bing, используют Web-роботы для индексации всех страниц, которые они находят в Сети. По умолчанию, эти роботы пытаются проанализировать весь ваш сайт. В тоже время, большинство сайтов имеют такую информацию, которая не должна быть проиндексирована, так как является либо техническими данными администратора сайта, либо просто не подлежит публикации. Файл robots.txt позволяет определить, какие ресурсы сайта не должны попасть в индексацию роботами. Стоит учитывать, что разные вредоносные и шпионские роботы могут игнорировать инструкции этого файла, поэтому не используйте его для закрытия доступа к секретным данным.

Файл robots.txt является набором инструкций для программ-роботов, сканирующих все WEB ресурсы сети Интернет, в том числе и ваш сайт. Поисковые алгоритмы таких интернет-гигантов поиска, как Google и Bing, используют Web-роботы для индексации всех страниц, которые они находят в Сети. По умолчанию, эти роботы пытаются проанализировать весь ваш сайт. В тоже время, большинство сайтов имеют такую информацию, которая не должна быть проиндексирована, так как является либо техническими данными администратора сайта, либо просто не подлежит публикации. Файл robots.txt позволяет определить, какие ресурсы сайта не должны попасть в индексацию роботами. Стоит учитывать, что разные вредоносные и шпионские роботы могут игнорировать инструкции этого файла, поэтому не используйте его для закрытия доступа к секретным данным.